Siri necesita un trasplante de cerebro. Lleva tiempo diciéndolo su creador, Dag Kittlaus, a quien Steve Jobs reclutó para convertir esa prometedora app en una parte esencial del iPhone. Aquello fue, en 2011, un hito en la aplicación de la inteligencia artificial (IA): por primera vez la gente hablaba con una máquina y le pedía que hiciera cosas o buscase información, aunque las respuestas no fuesen siempre satisfactorias o se convirtieran en un meme. Tras unos años de muy escasa innovación, Siri se vio superada por las capacidades de Alexa, el asistente de voz de Amazon. Pero fue la llegada de ChatGPT en 2022 lo que dejó definitivamente en evidencia a Siri, a la que ya es difícil llamarle inteligente frente a los nuevos chatbots de IA generativa, que a su lado parecen superdotados.Ahora, según una filtración publicada por Bloomberg, Apple está valorando usar los modelos de lenguaje generativos (LLMs) de OpenAI y de Anthropic —los mismos que están detrás, respectivamente, de ChatGPT y su rival Claude— para reprogramar Siri desde cero. El objetivo de Apple sería lanzar por fin, a partir de finales de 2026, una nueva generación de su asistente capaz de conversar con naturalidad con los usuarios y entender mucho mejor sus necesidades. Tras esa filtración, las acciones de Apple repuntaron en las horas siguientes.Más informaciónEsa posible llegada de ayuda externa serviría para sacar al gigante tecnológico del atolladero en el que se ha metido con la IA: su fracaso con una primera renovación de Siri, más modesta, le ha llevado a dar un frenazo a las expectativas que generó al presentar Apple Intelligence en 2024 en su conferencia WWDC. Así, en la última edición de ese encuentro mundial de Apple con programadores de apps, celebrado el pasado mes de junio, la compañía dio un giro completo a la manera de presentar su apuesta para competir en la carrera de la IA generativa.Si en la edición del año pasado, el consejero delegado Tim Cook y sus directivos dedicaron 40 minutos de la conferencia inaugural a su servicio Apple Intelligence, en 2025 fueron tan solo 4 minutos en los que no anunciaron ni una sola función nueva. Simplemente revisaron los logros sí conseguidos y comentaron que las nuevas funciones inteligentes de Siri no habían llegado a “cumplir con los estándares de calidad de la compañía” y necesitarían más tiempo para lanzarlas “a lo largo del próximo año”.El problema es que, en la WWDC de junio de 2024, Apple había demostrado —pero en un vídeo, no con un iPhone real en directo— algunas de esas funciones, como preguntarle a Siri “¿A qué hora llega el vuelo de mi madre?” y que el asistente de voz fuese capaz de responder rebuscando entre los mensajes y correos electrónicos del usuario, y procesando esa información privada del usuario que está almacenada en su teléfono, sin necesidad de llevarla a la nube como hace la competencia. Meses después, Apple llegó incluso a lanzar un anuncio que promocionaba esa nueva “inteligencia personal” para fomentar las ventas de sus nuevos iPhone 16. En ese anuncio, Siri sacaba de un compromiso a la actriz Bella Ramsey, la protagonista de la serie The Last of Us: ella no recordaba el nombre de una persona, con la que estaba a punto de cruzarse y con la que había tenido una reunión en una determinada cafetería meses antes; esa información era suficiente para que Siri encontrase el nombre analizando sus citas previas. Demandas por publicidad engañosaCon el paso del tiempo, todo eso se ha quedado en una ficción. Al menos, para los usuarios que esperaban esas funciones, y quizás se compraron un teléfono de último modelo para poder tenerlas; pues el servicio Apple Intelligence no funcionaba en los iPhones del 90% de los usuarios cuando fue anunciado. Y de entrada, los iPhone 16 no venían con la nueva inteligencia de Apple cuando salieron a la venta en septiembre de 2024 y, aunque sí fueron llegando las primeras funciones de IA generativa en los siguientes meses —con algunos fallos muy polémicos—, las esperadas nuevas capacidades de Siri no aparecían en las sucesivas actualizaciones de iOS 18.Esa primera gran renovación de Siri desde 2011 estaba programada para la pasada primavera, cuando Apple sí estrenó su IA generativa en otros idiomas distintos al inglés —entre ellos, el español—. Pero días antes de esa actualización a iOS 18.4 —que llegó a principios de abril—, la compañía reconoció que todavía no iba a lanzar la nueva “inteligencia personal” de Siri, sin dar a conocer una nueva fecha de lanzamiento; y además, retiró el anuncio de Bella Ramsey. Las demandas por publicidad engañosa comenzaron a acumularse. Y el reputado analista tecnológico John Gruber, tras una larga trayectoria profundizando en las bondades de los productos de Apple, publicó un demoledor artículo en el que acusaba a la compañía de haber vendido humo, al simular en sus vídeos unas demostraciones de una nueva Siri que en realidad no funcionaban bien.Los motivos técnicos del atascoEn varias entrevistas durante la WWDC celebrada este junio, Craig Federighi —el vicepresidente de Apple encargado de su software— sí dio las primeras explicaciones de lo que había pasado. Federighi comentó que el gigante tecnológico había estado trabajando en dos versiones diferentes del código informático que hace funcionar a Siri: una para poder lanzar las nuevas funciones de inteligencia personal cuanto antes; y una segunda, más definitiva. Y el directivo admitió que la arquitectura de primera generación que Apple estaba desarrollando “era demasiado limitada” y, por eso, finalmente Apple “decidió que necesitaba cambiar completamente a Siri a una arquitectura de segunda generación”.Otro analista externo a la empresa, Mark Gurman, da una explicación algo más técnica de cuál ha sido el fallo. Citando fuentes anónimas dentro de la compañía de la manzana, Gurman sostiene que esa primera versión de la nueva arquitectura de Siri era un híbrido entre código de programación viejo —usado para resolver las tareas de siempre, como programar una alarma— y código nuevo —para las funciones de inteligencia personal y manejar datos privados—. Aunque por separado, cada función funcionaba, al juntar todas el sistema se volvía inestable y las respuestas poco fiables. La segunda versión de esa nueva arquitectura para Siri ya está totalmente armada con código nuevo, según Gurman.Esta explicación técnica, compatible con las declaraciones públicas de los directivos de Apple, pone de relieve que en la era de la IA generativa es mucho más fácil empezar de cero, como hicieron los creadores de ChatGPT o Claude, que adaptar sistemas de IA que ya existían. Bien lo saben en Amazon, que también ha patinado con la renovación de Alexa y ha tenido que recurrir a la tecnología de Anthropic para por fin lanzar Alexa+, un asistente de voz de nueva generación cuyo despliegue está siendo muy lento.Gurman, que acaba de publicar en Bloomberg la filtración de que la compañía de la manzana está valorando usar la IA de OpenAI o Anthropic en lugar de sus propios modelos de lenguaje, aclara que este movimiento no está destinado a que Apple dote a Siri de la inteligencia personal que sufrido ya varios retrasos. Se trataría de una renovación mucho más profunda, de realmente reprogramar Siri desde cero y hacerle, como reclama su inventor Dag Kittlaus, todo un trasplante de cerebro.

El frenazo de Apple con la IA: por qué ha fracasado en la renovación de Siri | Tecnología

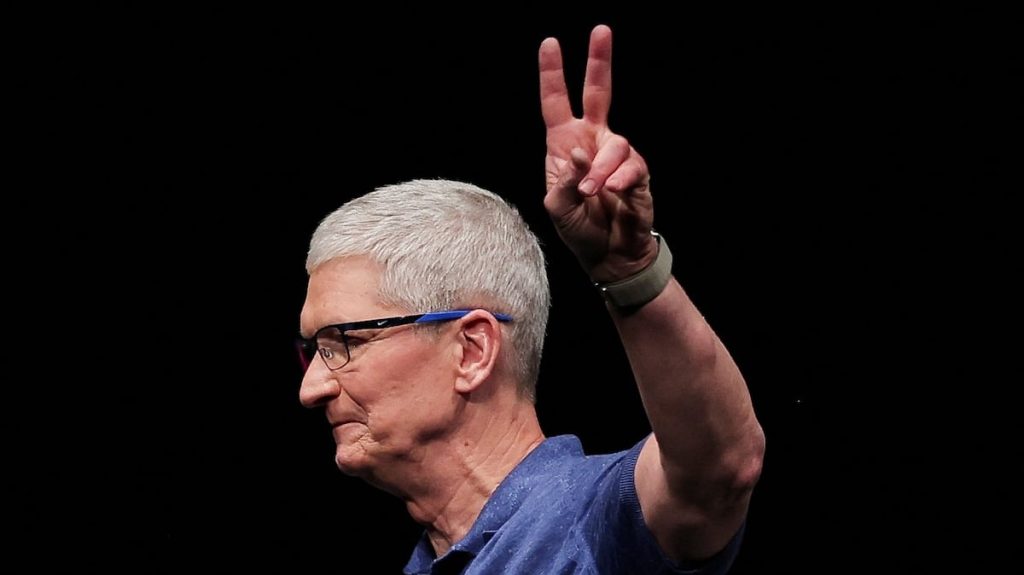

Shares: